Gastbeitrag von Fabian Liebig (Optimizely)

Wie Start-ups mit A/B Tests ihre Conversion erhöhen können

“Build, measure, learn” heißt die Devise des Lean Startup, derjenigen Methode, der die wohl meisten Startups fast religiös verschrieben sind, um ihre Chancen auf Erfolg zu erhöhen. “Baue nichts, was am Ende von niemandem genutzt wird” könnte man die Devise ins Deutsche übertragen. Um dies zu vermeiden, so sagt die Methode von Eric Ries, sollte man kontinuierlich testen. Testen hilft dabei, zum Beispiel den sogenannten Product/Market Fit zu erreichen. Das Motto von Paul Graham, dem Gründer des Y-Combinator, lautet seit des Starts des extrem erfolgreichen Accelerators: “Make things people want.” Teil der Strategie eines jeden Startups sollte also sein, zu testen, ob es überhaupt jemanden gibt, der mein Produkt oder meinen Service kaufen würde.

Was hat dies mit A/B Testen zu tun?

Wenn man eine Webseite hat, über die man etwas verkauft, dann möchte man natürlich, dass so viele Personen wie möglich diese Webseite besuchen. Wenn man für 100 Besucher zwei Verkäufe verzeichnen kann, dann lässt sich sehr leicht errechnen, wie ich das Doppelte erreiche – nämlich indem ich den Traffic verdopple. Mehr Besucher erhöhen die Wahrscheinlichkeit, dass ich mehr Kunden gewinne.

Wäre es nicht großartig, wenn ich mit der gleichen Menge an Traffic auf meine Webseite doppelt so viele Kunden generieren könnte? A/B Tests machen genau das möglich.

Wie funktionieren A/B Tests?

Beim A/B Testen können Startups herausfinden, wie sie die bestmögliche Version ihrer Webseite erreichen können.

Mit A/B Tests erstellt man eine modifizierte Version der Webseite. Man könnte zum Beispiel den Text auf der Seite verändern, ein Kontaktformular kürzen, Bilder austauschen oder das Layout der Seite verändern. Dann testet man die Originalversion der Seite gegen die veränderte Seite. 50% sehen das Original (Variante A), die andere Hälfte sieht die Variante B. Es ist nun möglich in Echtzeit zu messen, welche der beiden Varianten zu mehr Klicks, Leads, Downloads oder Verkäufen führt, je nachdem, welche Ziele man mit seiner Webseite verfolgt.

Einige Startups in Deutschland nutzen A/B Tests bereits sehr aktiv. Daan Loening, Geschäftsführer von Kinderfee zum Beispiel, testet schon seit mehr als zweieinhalb Jahren auf seiner Webseite. “Früher haben wir in Sequenzen getestet”, erinnert er sich. “Dies ist nicht nur sehr langsam und aufwendig, es ist auch sehr ungenau, da sich der Traffic im Wochenvergleich natürlich stark unterscheiden kann.”

Im Vergleich zu früher ist es heutzutage wesentlich einfacher, A/B Tests auf Webseiten durchzuführen.

“Heute testet bei uns das Marketing. Früher war es für das Marketing zu kompliziert und Tests mussten von den Technikern erst gebaut und dann live geschaltet werden. Das ist heutzutage zum Glück nicht mehr notwendig.” Daan fügt hinzu, dass neue Mitarbeiter im Marketing von Kinderfee als eine der ersten Aufgaben eine Testidee für die Kinderfee Webseite entwickeln müssen. “Das hilft dabei, eine neue Perspektive zu erlangen und so neue Hypothesen für Tests zu entwickeln.”

A/B Tests in der Praxis

Wie hole ich aus meinem Traffic das Meiste heraus?

Wie sollte meine Seite aussehen, damit Besucher nicht abspringen, sondern zu Kunden werden? Dies sind nur zwei der wichtigsten Fragen, die A/B Tests einem Startup in der Praxis beantworten können. Hier ein paar Beispiele, wie deutsche Startups schon früh den Aspekt des ständigen Testens in ihre Produkt- und Webseitenentwicklung integriert haben.

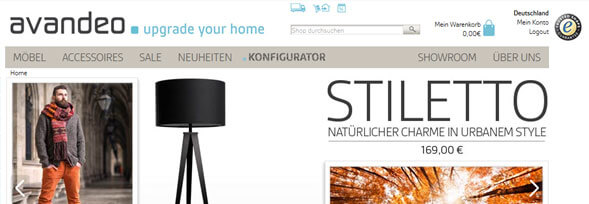

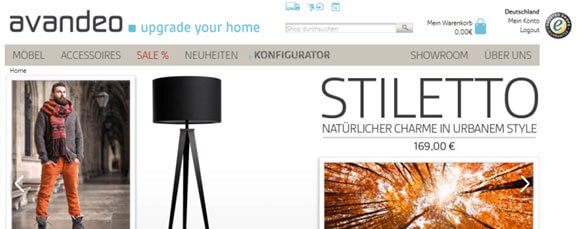

Beispiel 1: avandeo

Sebastian Dostal von avandeo wollte wissen, wie sich die Klicks und auch die Verkäufe auf die Rubrik “Sale” erhöhen ließen. Er war der Annahme, dass der Bereich “Sale” klarer herausstechen musste, damit mehr Besucher dort klickten. Also setzte Sebastian einen A/B Test auf, in dem er die Originalversion in 2 Punkten veränderte. Anstatt “Sale” sah die Hälfte der Besucher von avandeo “Sale %”. Zusätzlich wurde die Schriftfarbe von schwarz zu rot verändert. Dann schaltete Sebastian den Test live und konnte schon bald die Ergebnisse des Tests auswerten. Welche Version würde besser funktionieren?

Original

Variante B

Ergebnis:

Sebastian sah einen klaren Trend. “Sale%” in rot, also die veränderte Variante B, sah wesentlich mehr Klicks, was sich dann auch positiv auf die Anzahl der Bestellungen in dieser Rubrik für avandeo auswirkte.

Beispiel 2: Gutscheinsammler.de

Tobias Klien von Gutscheinsammler kam im Mai dieses Jahres zum A/B Testen. Die Seite Gutscheinsammler.de sollte nicht nur neu programmiert werden, auch optisch sollte sich einiges tun. “Es war ein Haufen Änderungen und wir haben schon selber erfahren müssen, dass ein farblich falscher Button die Conversion komplett zerstören kann”, meinte Tobias. Nur durch A/B Tests konnte Gutscheinsammler herausfinden, was auf der neuen Seite funktionieren würde und hat deswegen in der “Übergangsphase” von altem zu neuem Design sehr viel getestet. Tobias testete unter anderem den Einfluss von großen Shopbildern auf die Klicks der einzelnen Angebote und auf die Anmeldung zum Newsletter.

“Das Testen wichtig ist, weiß eigentlich jeder”, meinte Tobias. “Das Problem ist, dass es bisher immer sehr kompliziert war und so den „Profis“ vorbehalten war. Mittlerweile haben es die Toolanbieter begriffen und setzen auch bei ihren eigenen Tools auf Einfachheit und Usability. Das ist ein großer Pluspunkt. Wir haben 2011 A/B Toolanbieter getestet, damals war es aber weit weg von der heutigen Komfortabilität.”

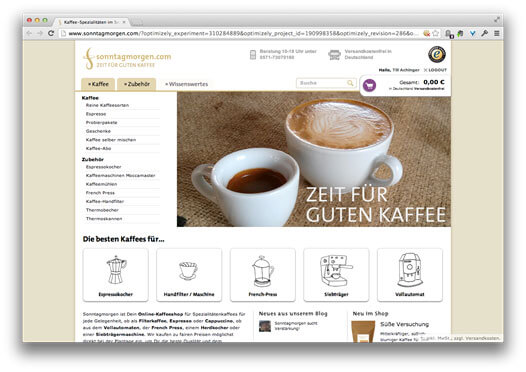

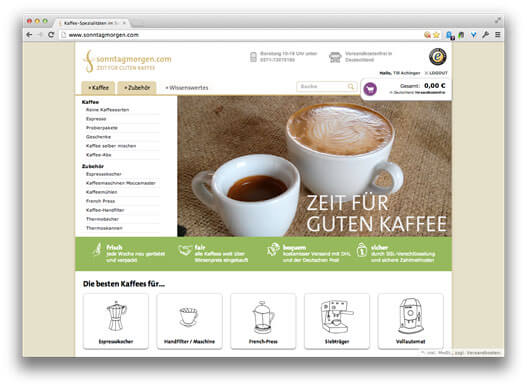

Beispiel 3: Sonntagmorgen

A/B Tests helfen dabei, die Präferenzen von Kunden besser kennenzulernen. Till von Sonntagmorgen testet seit längerem auf der Webseite. Er wollte den Einfluss von gewissen Trustargumenten und Zusätzen wie zum “frisch”, “sicher”, “bequem” auf die Conversionsrate wissen. Diese Adjektive sollten dem Besucher der Homepage die Vorteile von Sonntagmorgen auf übersichtliche Weise näherbringen. Die Elemente wurden in grün direkt unter dem großen Bild platziert. Dann ließ Till einen Test laufen um zu sehen, welche der Varianten mehr Klicks erhalten würde.

Original

Variante B

Ergebnis:

Till war extrem überrascht. Während er erwatet hatte, dass die zusätzlichen Attribute Klicks erhöhten, war das komplette Gegenteil der Fall. Die reduzierte Variante der Homepage ohne diese Elemente erzielte 10% mehr Conversions und erhöhte im Endeffekt auch den Umsatz. Daten übertrumpfen Intuition und “best practices” aus Usability, mal wieder. Ohne Tests hätte Till von Sonntagmorgen nicht im Traum geglaubt, dass die grüne Leiste mit Trustargumenten nicht funktionieren würde.

Was sollte ich als Startup beachten?

Ein Startup unterscheidet sich in vielerlei Hinsicht von etablierteren Unternehmen. Einer der bedeutendsten Unterschiede ist ganz klar Traffic. Einige Startups klagen: “Ich würde gerne testen, aber mein Traffic ist zu gering”. Traffic zu gering, um in absehbarer Zeit Ergebnisse zu erwarten? Startups in sehr früher Phase haben vergleichsweise wenig Traffic.

Hier ist zu raten, mit den Seiten zu beginnen, die am meisten Traffic erhalten.

Till hatte zu Beginn mit ähnlichen Problemen zu kämpfen und sich daher hauptsächlich auf das Testen der Startseite von Sonntagmorgen konzentriert. Nachdem er dann auch auf Einzelseiten mehr Traffic verzeichnete, konnte er Tests auch auf anderen Unterseiten ausrollen.

Kleine vs. große Veränderungen

Wenn man noch nicht so viel Traffic hat, kann man logischerweise nur auf wenige Daten über seine Besucher zurückgreifen. Wenn man also nur sehr kleine und kaum wahrnehmbare Veränderungen testet, dann lernt man nur sehr sehr kleine Unterschiede über seine Besucher kennen. Um letztendlich schon früh viel über seine Besucher zu lernen und die Seite zu optimieren, könnte man statt kleinen Veränderungen drastische Veränderungen durchführen. So lernt man schneller mehr über seine Besucher. Danach kann man iterativ vorgehen und immer weiter im Detail optimieren.

Stefan Decker von Stylemarks erklärt das Testen von kleinen kontra großen Veränderungen. “Da wir sehr zahlengetrieben arbeiten, führen wir seit dem ersten Tag A/B Tests durch. Anfangs hat sich dies auf größere Änderungen wie z.B. eine neue Navigationsstruktur bezogen, seitdem wir Optimizely benutzen benötigen wir allerdings fast keine Unterstützung unserer Entwickler mehr und testen praktisch alle relevanten Elemente unserer Seite. Dadurch lassen sich sehr schnell neue Ideen testen und objektive Entscheidungen treffen.”

Warum sollte jedes Startup mit dem Testen beginnen?

1. Mehr Umsatz bei quasi gleichem Budget

Unternehmen geben im Durchschnitt 9 mal so viel Geld für Traffic Generierung aus als für die Optimierung dieses Traffics auf der Webseite. Wenn man erkennt, dass bei einem Großteil des Traffics nicht zum Kunden wird, dann macht es einfach Sinn, einen Teil dieses Budgets statt in Anzeigen in Optimierung zu investieren.

2. Kontinuierliche und schnelle Weiterentwicklung

Eine Webseite ist nicht statisch. Traffic verändert sich, das Angebot und der Inhalt auf der Seite verändern sich und so muss man agil bleiben. Dies kann man dank A/B Tests sehr einfach machen. Ständiges Testen bietet für Startups das Potenzial zur schnellen Weiterentwicklung. Stefan Decker von Stylemarks fasste das perfekt zusammen. “Viele Unternehmen schrecken vor A/B Tests zurück, da sie glauben, dies würde die Geschwindigkeit der Entwicklung bremsen, da für Entscheidungen zunächst Tests erforderlich sind. Tatsächlich können A/B Tests aber die Geschwindigkeit der Entwicklung drastisch verbessern, da ohne sie eine große Hemmschwelle besteht, Änderungen zu implementieren.”

3. Zufriedenere Besucher = neue Kunden

Wenn man als Startup testet und optimiert dann kann man Klicks, Downloads, Leads und Umsatz verbessern. Allerdings macht man auch die Besucher glücklicher. Wenn die Besucher finden was sie suchen, dann steigt die Chance, dass diese zu Kunden werden.

4. Lernen, lernen, lernen

Besonders zu Anfang ist es für jedes Startup essenziell, mehr über seine Besucher zu lernen. Was mögen sie? Wonach suchen sie? Wie kann ich sie am besten durch den “Conversion Funnel” leiten? Jeder Test lässt uns mehr über unseren Traffic und über unsere potenziellen Kunden erfahren.

5. Objektive Entscheidungen treffen

Anstatt stundenlang im Team darüber zu diskutieren, welche die geeignete Buttonfarbe ist oder welche Elemente eine Navigationslesite unbedingt haben muss und welche man weglassen könnte, sollte man einfach die Daten entscheiden lassen – getreu dem Motto “Test, Measure, Optimize.”

Zur Person

Fabian Liebig ist Marketingmanager DACH bei Optimizely, der weltweit führenden Plattform für A/B- und Multivariate Tests. Optimizely hilft Unternehmen, auf Daten basierende Entscheidungen zu treffen und so mehr Webseitenbesucher in Kunden zu verwandeln. Fabian bloggt unter: blog.optimizely.de